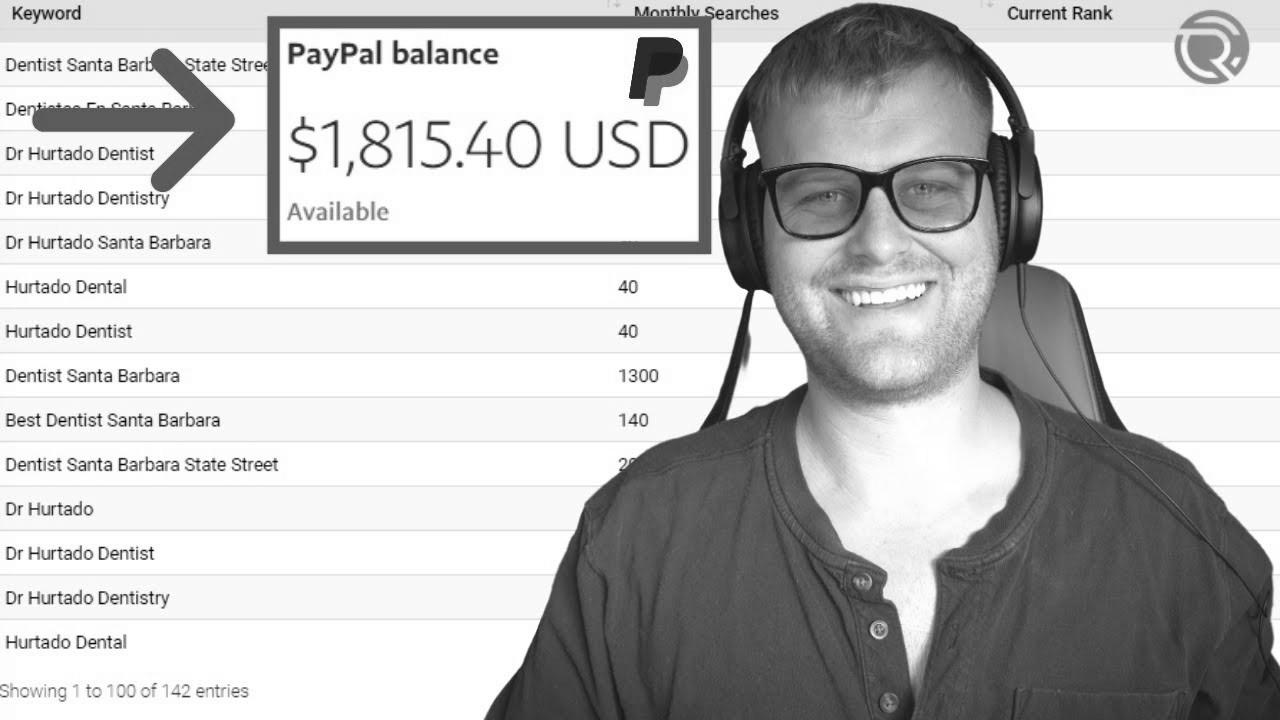

How To Make $1,000 Per Month With search engine optimization Rank Checker

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

Make Seo , How To Make $1,000 Per Month With search engine optimisation Rank Checker , , 3X_Xzkq5GjQ , https://www.youtube.com/watch?v=3X_Xzkq5GjQ , https://i.ytimg.com/vi/3X_Xzkq5GjQ/hqdefault.jpg , 1121 , 5.00 , Get started being profitable with search engine marketing audits and grab the free template at: https://chasereiner.com 1. Seize Shine Ranker 2. Find a ... , 1634924075 , 2021-10-22 19:34:35 , 00:10:13 , UC6z07Hh9Muy6urJgA0F0azg , Chase Reiner , 42 , , [vid_tags] , https://www.youtubepp.com/watch?v=3X_Xzkq5GjQ , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=3X_Xzkq5GjQ, #Month #search engine optimization #Rank #Checker [publish_date]

#Month #search engine optimization #Rank #Checker

Get started getting cash with search engine optimisation audits and grab the free template at: https://chasereiner.com 1. Grab Shine Ranker 2. Discover a ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die ersten Suchmaschinen im Internet an, das frühe Web zu sortieren. Die Seitenbesitzer erkannten schnell den Wert einer bevorzugten Positionierung in Ergebnissen und recht bald entstanden Unternehmen, die sich auf die Verfeinerung spezialisierten. In den Anfängen vollzogen wurde der Antritt oft über die Übermittlung der URL der geeigneten Seite an die verschiedenartigen Suchmaschinen. Diese sendeten dann einen Webcrawler zur Betrachtung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Web Server der Anlaufstelle, wo ein weiteres Anwendung, der sogenannte Indexer, Angaben herauslas und katalogisierte (genannte Ansprüche, Links zu anderweitigen Seiten). Die frühen Typen der Suchalgorithmen basierten auf Informationen, die anhand der Webmaster selbst bestehen werden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Netz wie ALIWEB. Meta-Elemente geben einen Überblick über den Thema einer Seite, dennoch setzte sich bald raus, dass die Anwendung der Vorschläge nicht gewissenhaft war, da die Wahl der gebrauchten Schlüsselworte durch den Webmaster eine ungenaue Präsentation des Seiteninhalts widerspiegeln konnte. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Seiten bei charakteristischen Benötigen listen.[2] Auch versuchten Seitenersteller vielfältige Attribute binnen des HTML-Codes einer Seite so zu lenken, dass die Seite besser in den Ergebnissen gelistet wird.[3] Da die zeitigen Suchmaschinen im Netz sehr auf Merkmalen abhängig waren, die ausschließlich in den Taschen der Webmaster lagen, waren sie auch sehr empfänglich für Falscher Gebrauch und Manipulationen in der Positionierung. Um gehobenere und relevantere Urteile in den Suchergebnissen zu erhalten, musste ich sich die Inhaber der Suchmaschinen an diese Gegebenheiten integrieren. Weil der Triumph einer Suchmaschine davon anhängig ist, relevante Suchresultate zu den gestellten Suchbegriffen anzuzeigen, konnten unangebrachte Testurteile dazu führen, dass sich die Benutzer nach sonstigen Entwicklungsmöglichkeiten für den Bereich Suche im Web umgucken. Die Lösung der Suchmaschinen fortbestand in komplexeren Algorithmen fürs Rang, die Gesichtspunkte beinhalteten, die von Webmastern nicht oder nur nicht ohne Rest durch zwei teilbar leicht beeinflussbar waren. Larry Page und Sergey Brin entwarfen mit „Backrub“ – dem Stammvater von Suchmaschinen – eine Suchseite, die auf einem mathematischen Suchsystem basierte, der mit Hilfe der Verlinkungsstruktur Webseiten gewichtete und dies in den Rankingalgorithmus eingehen ließ. Auch übrige Search Engines betreffend bei Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein. Google

Please do a video on how to do outreach on loom

What can we do if they aren't ranking for any relevant keywords?